- Ce este AI Hacking?

- Cum este utilizată inteligența artificială pentru criminalitatea informatică?

- Exemple de atacuri cibernetice ale IA

- Modul în care inteligența artificială poate fi utilizată în mod abuziv pentru a dezvolta programe malware: O analiză a experților OPSWAT

- Cum să vă apărați împotriva atacurilor cibernetice bazate pe inteligența artificială

- Întrebări frecvente (FAQ)

Ce este AI Hacking?

Hackingul AI este utilizarea inteligenței artificiale pentru a îmbunătăți sau automatiza atacurile cibernetice. Aceasta permite actorilor amenințători să genereze cod, să analizeze sisteme și să eludeze sistemele de apărare cu un efort manual minim.

Modelele de inteligență artificială, în special modelele mari de limbaj (LLM), fac dezvoltarea atacurilor mai rapidă, mai ieftină și mai accesibilă pentru hackerii mai puțin experimentați. Rezultatul este un nou set de atacuri AI care este mai rapid, mai scalabil și adesea mai greu de oprit cu apărarea tradițională.

Ce este un AI Hacker?

Un hacker AI este un actor amenințător care utilizează inteligența artificială pentru a automatiza, îmbunătăți sau extinde atacurile cibernetice. Hackerii cu inteligență artificială utilizează modele de învățare automată, inteligență artificială generativă și agenți autonomi pentru a ocoli controalele de securitate, pentru a crea atacuri de phishing extrem de convingătoare și pentru a exploata vulnerabilitățile software la scară largă.

Acești atacatori pot include atât operatori umani care utilizează instrumente de inteligență artificială, cât și sisteme semi-autonome care execută sarcini cu un aport uman minim. Atacatorii umani care utilizează AI sunt persoane din lumea reală - infractori, script kiddies, hacktiviști sau actori ai statelor naționale - care utilizează modele AI pentru a-și spori capacitățile de atac.

Agenții de hacking autonomi sunt fluxuri de lucru bazate pe inteligență artificială care pot îndeplini sarcini în lanț - cum ar fi recunoașterea, generarea încărcăturii utile și eludarea - cu o supraveghere minimă. Deși sunt încă ghidați de obiective definite de om, acești agenți pot funcționa semi-independent odată lansați, executând atacuri în mai multe etape mai eficient decât instrumentele manuale.

Cum este utilizată inteligența artificială pentru criminalitatea informatică?

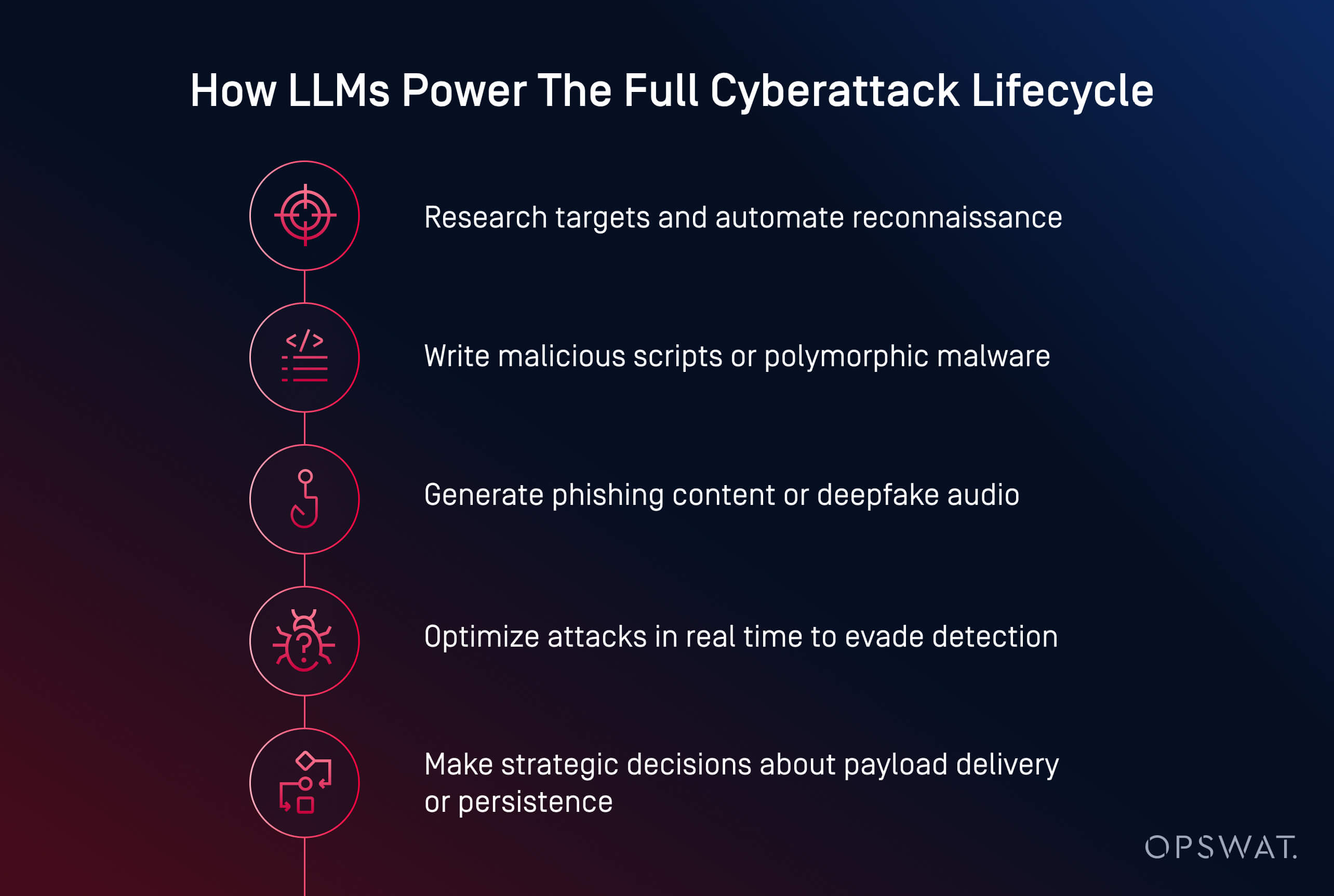

Actorii din domeniul amenințărilor cu IA utilizează în prezent inteligența artificială pentru a lansa atacuri cibernetice mai rapide, mai inteligente și mai adaptabile. De la crearea de programe malware la automatizarea phishing-ului, AI transformă criminalitatea informatică într-o operațiune scalabilă. În prezent, AI poate genera coduri malițioase, redacta conținut de phishing convingător și chiar ghida atacatorii prin lanțuri complete de atacuri.

Infractorii cibernetici folosesc inteligența artificială în mai multe domenii principale:

- Generarea încărcăturii utile: Instrumente precum HackerGPT și WormGPT pot scrie programe malware ofuscate, pot automatiza tacticile de evaziune și pot converti scripturi în executabile. Acestea sunt exemple de atacuri AI generative, adesea observate în atacurile cibernetice cu agenți AI, în care modelele iau decizii autonome.

- Inginerie socială: AI creează e-mailuri de phishing realiste, clonează vocile și generează deepfakes pentru a manipula victimele mai eficient.

- Recunoaștere și planificare: AI accelerează cercetarea țintelor, cartografierea infrastructurii și identificarea vulnerabilităților.

- Automatizare la scară largă: Atacatorii folosesc inteligența artificială pentru a lansa campanii în mai multe etape, cu un aport uman minim.

Potrivit Institutului Ponemon, inteligența artificială a fost deja utilizată în campanii ransomware și atacuri de phishing care au provocat perturbări operaționale majore, inclusiv furtul de acreditări și închiderea forțată a peste 300 de locații de vânzare cu amănuntul în timpul unei breșe din 2023.

Mai multe modele emergente remodelează peisajul amenințărilor:

- Democratizarea atacurilor cibernetice: Modele open-source precum LLaMA, ajustate pentru infracțiuni, sunt acum disponibile pentru oricine are putere de calcul locală

- Reducerea barierei de intrare: Ceea ce odinioară necesita cunoștințe de specialitate poate fi realizat acum prin simple solicitări și câteva clicuri

- Succes sporit în materie de evaziune: Programele malware generate de inteligența artificială se ascund mai bine de detecția statică, de sandbox-uri și chiar de analiza dinamică

- Modele Malware-as-a-Service (MaaS): Infractorii cibernetici integrează capacitățile AI în kituri pe bază de abonament, facilitând lansarea de atacuri complexe la scară largă

- Utilizarea inteligenței artificiale în încălcări reale: Institutul Ponemon raportează că atacatorii au folosit deja inteligența artificială pentru a automatiza țintirea ransomware, inclusiv în incidente care au forțat închiderea unor operațiuni majore

Phishing și inginerie socială bazate pe IA

Phishing-ul și ingineria socială cu ajutorul inteligenței artificiale transformă înșelătoriile tradiționale în atacuri scalabile, personalizate și mai greu de detectat. Actorii amenințători folosesc acum modele generative pentru a crea e-mailuri credibile, a clona voci și chiar a produce apeluri video false pentru a-și manipula țintele.

Spre deosebire de înșelătoriile tradiționale, e-mailurile de phishing generate de inteligența artificială sunt rafinate și convingătoare. Instrumente precum ChatGPT și WormGPT produc mesaje care imită comunicările interne, serviciul clienți sau actualizările HR. Atunci când sunt asociate cu datele violate, aceste e-mailuri devin personalizate și au mai multe șanse de reușită.

De asemenea, inteligența artificială alimentează forme mai noi de inginerie socială:

- Atacurile de clonare a vocii imită executivi folosind scurte mostre audio pentru a declanșa acțiuni urgente, cum ar fi transferurile bancare

- Atacurile Deepfake simulează apeluri video sau întâlniri la distanță pentru escrocherii cu miză mare

Într-un incident recent, atacatorii au folosit e-mailuri generate de inteligența artificială în timpul unei perioade de înscriere la beneficii, dându-se drept HR pentru a fura acreditările și a obține acces la înregistrările angajaților. Pericolul constă în iluzia de încredere. Atunci când un e-mail pare intern, vocea pare familiară, iar solicitarea pare urgentă, chiar și personalul instruit poate fi înșelat.

Descoperirea și exploatarea vulnerabilităților AI

Inteligența artificială accelerează modul în care atacatorii găsesc și exploatează vulnerabilitățile software. Ceea ce înainte dura zile întregi de sondare manuală se poate face acum în câteva minute, folosind modele de învățare automată antrenate pentru recunoaștere și generarea de exploit-uri.

Actorii amenințători utilizează inteligența artificială pentru a automatiza scanarea vulnerabilităților în sistemele publice, identificând configurații slabe, software învechit sau CVE-uri nepatchate. Spre deosebire de instrumentele tradiționale, AI poate evalua contextul expunerii pentru a-i ajuta pe atacatori să prioritizeze țintele de mare valoare.

Printre tacticile comune de exploatare asistată de IA se numără:

- Fuzzing automatizat pentru descoperirea mai rapidă a vulnerabilităților de tip zero-day

- Generarea de scripturi personalizate pentru executarea codurilor de la distanță sau mișcări laterale

- Spargerea parolelor și atacurile prin forță brută optimizate prin învățarea modelelor și modele probabilistice

- Roboți de recunoaștere care scanează rețelele în căutarea activelor cu risc ridicat cu zgomot minim

Modelele generative precum LLaMA, Mistral sau Gemma pot fi ajustate pentru a genera sarcini utile personalizate, cum ar fi coduri shell sau atacuri prin injectare, pe baza caracteristicilor specifice sistemului, ocolind adesea măsurile de protecție integrate în modelele comerciale.

Tendința este clară: inteligența artificială permite atacatorilor să descopere și să acționeze asupra vulnerabilităților la viteza mașinii. Potrivit Ponemon Institute, 54% dintre profesioniștii din domeniul securității cibernetice consideră că vulnerabilitățile neparate reprezintă principala lor preocupare în era atacurilor bazate pe inteligența artificială.

Malware și Ransomware bazate pe inteligența artificială

Creșterea malware-ului generat de inteligența artificială înseamnă că apărarea tradițională nu mai este suficientă. Atacatorii dispun acum de instrumente care gândesc, se adaptează și evadează - adesea mai repede decât pot răspunde apărătorii umani.

Ransomware-ul și programele malware polimorfe bazate pe inteligența artificială redefinesc modul în care evoluează atacurile cibernetice. În loc să scrie sarcini utile statice, atacatorii folosesc acum inteligența artificială pentru a genera malware polimorf - cod care se schimbă constant pentru a evita detectarea.

Amenințările de tip ransomware sunt, de asemenea, în evoluție. Inteligența artificială poate ajuta la alegerea fișierelor care urmează să fie criptate, la analiza valorii sistemului și la determinarea momentului optim pentru detonare. Aceste modele pot, de asemenea, să automatizeze geofencing-ul, eludarea sandbox-ului și execuția în memorie - tehnici utilizate în mod obișnuit de actorii de amenințare avansați.

Exfiltrarea datelor cu ajutorul inteligenței artificiale se adaptează dinamic pentru a evita detectarea. Algoritmii pot comprima, cripta și extrage pe furiș date prin analizarea tiparelor de trafic, evitând declanșatoarele de detectare. Unii agenți malware încep să ia decizii strategice: aleg când, unde și cum să se exfiltreze pe baza a ceea ce observă în mediul compromis.

Exemple de atacuri cibernetice ale IA

Atacurile cibernetice ale IA nu mai sunt teoretice; acestea au fost deja utilizate pentru a fura date, a ocoli sistemele de apărare și a se da drept oameni la scară largă.

Exemplele din cele trei categorii notabile de mai jos arată că atacatorii nu mai au nevoie de competențe avansate pentru a provoca pagube grave în atacurile cibernetice. Inteligența artificială reduce bariera de intrare, crescând în același timp viteza, amploarea și discreția atacurilor. Apărătorii trebuie să se adapteze prin testarea proactivă a sistemelor integrate cu IA și prin implementarea unor măsuri de protecție care să țină seama atât de manipularea tehnică, cât și de înșelăciunea umană.

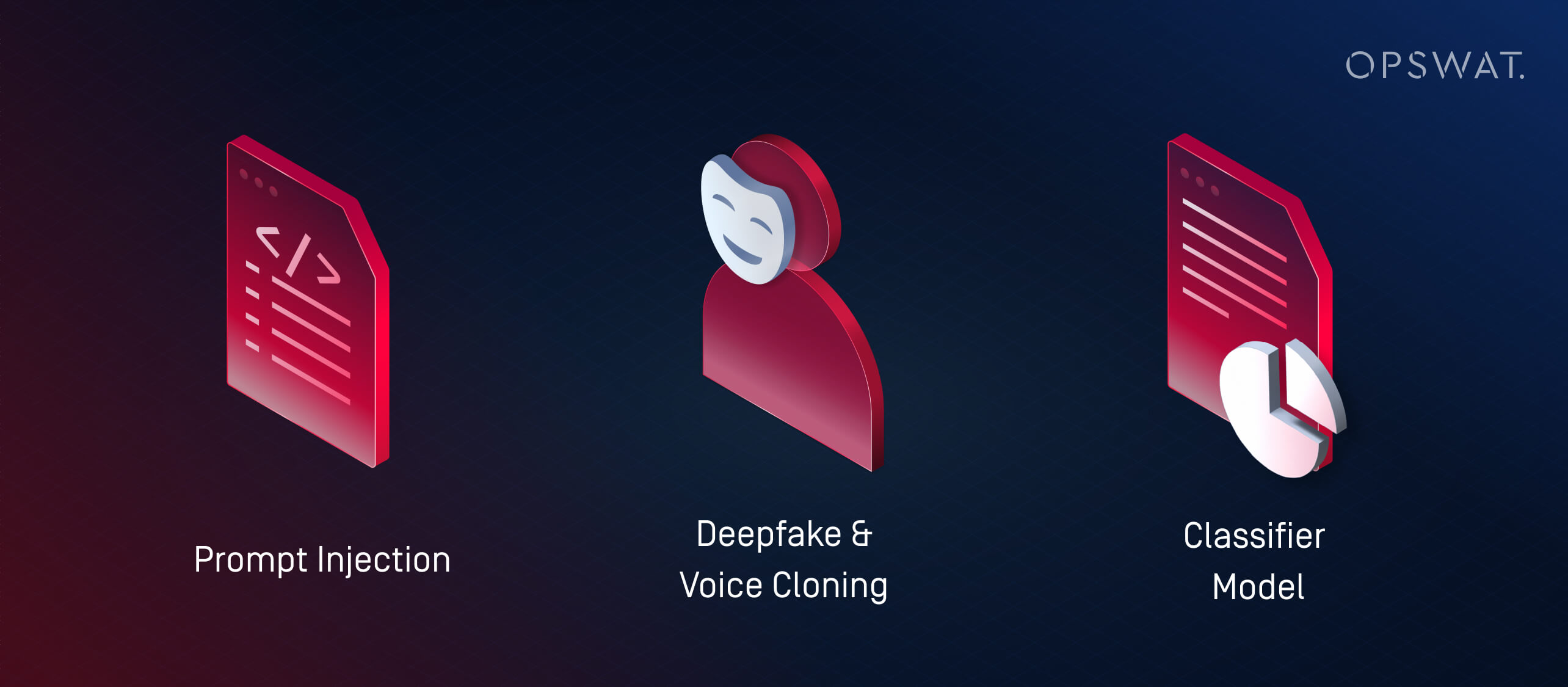

1. Ce sunt atacurile de injectare promptă?

Injectarea promptului este o tehnică prin care atacatorii exploatează vulnerabilitățile LLM-urilor (modele de limbaj de mari dimensiuni), furnizându-le date de intrare special concepute pentru a anula comportamentul dorit. Aceste atacuri exploatează modul în care LLM-urile interpretează și prioritizează instrucțiunile, de multe ori cu puțin sau deloc malware tradițional implicat.

În loc să utilizeze inteligența artificială pentru a lansa atacuri externe, injectarea promptă transformă propriile sisteme de inteligență artificială ale unei organizații în agenți de compromitere neintenționați. Dacă un LLM este încorporat în instrumente precum birourile de asistență, chatbot-urile sau procesoarele de documente fără măsurile de protecție adecvate, un atacator poate încorpora comenzi ascunse pe care modelul le interpretează apoi și acționează în consecință. Acest lucru poate duce la:

- Scurgerea de date private sau restricționate

- Executarea de acțiuni neintenționate (de exemplu, trimiterea de e-mailuri, modificarea înregistrărilor)

- Manipularea rezultatelor pentru a răspândi informații eronate sau pentru a declanșa acțiuni ulterioare

Aceste riscuri se amplifică în sistemele în care mai multe modele își transmit informații între ele. De exemplu, un prompt rău intenționat încorporat într-un document ar putea influența un rezumator AI, care apoi transmite informații eronate sistemelor din aval.

Pe măsură ce inteligența artificială devine tot mai integrată în fluxurile de lucru ale întreprinderilor, atacatorii vizează din ce în ce mai mult aceste modele pentru a compromite încrederea, a extrage date sau a manipula deciziile din interior.

2. Ce sunt atacurile Deepfake și Voice Cloning?

Atacurile de tip deepfake utilizează date audio sau video generate de inteligența artificială pentru a se da drept persoane în timp real. Asociate cu tactici de inginerie socială, aceste instrumente sunt utilizate pentru fraudă, furtul de acreditări și accesul neautorizat la sisteme.

Clonarea vocii a devenit deosebit de periculoasă. Cu doar câteva secunde de discurs înregistrat, actorii amenințători pot genera sunet care imită tonul, ritmul și inflexiunea. Aceste voci clonate sunt apoi utilizate pentru:

- să se dea drept directori sau manageri în timpul apelurilor urgente

- Păcăliți angajații să efectueze transferuri bancare sau să reseteze parolele

- Ocolirea sistemelor de autentificare vocală

Deepfakes fac un pas mai departe prin generarea de videoclipuri sintetice. Actorii amenințători pot simula un CEO în cadrul unui apel video în care solicită date confidențiale sau pot apărea în clipuri înregistrate în care "anunță" schimbări de politică care răspândesc dezinformare. Institutul Ponemon a raportat un incident în care atacatorii au folosit mesaje generate de inteligența artificială care se dădeau drept resurse umane în timpul perioadei de înscriere la beneficii a unei companii, ceea ce a dus la furtul de acreditări.

Pe măsură ce instrumentele de inteligență artificială devin mai accesibile, chiar și actorii amenințători mărunți pot genera imitații de înaltă fidelitate. Aceste atacuri ocolesc filtrele tradiționale de spam sau apărarea punctelor finale prin exploatarea încrederii.

3. Ce sunt atacurile asupra modelelor de clasificare (învățarea automată adversarială)?

Atacurile asupra modelelor de clasificare manipulează intrările sau comportamentul unui sistem de inteligență artificială pentru a forța decizii incorecte fără a scrie neapărat programe malware sau cod de exploatare. Aceste tactici fac parte din categoria mai largă a învățării automate de tip adversar.

Există două strategii principale:

- Atacuri de evaziune: Atacatorul creează o intrare care păcălește un clasificator să o identifice greșit, cum ar fi malware-ul care mimează fișiere inofensive pentru a ocoli motoarele antivirus

- Atacuri de otrăvire: Un model este antrenat sau ajustat pe baza unor date distorsionate în mod deliberat, modificându-i capacitatea de a detecta amenințările

Modelele supervizate sunt adesea "supraadaptate": ele învață modele specifice din datele de antrenament și ratează atacurile care deviază doar puțin. Atacatorii exploatează acest lucru folosind instrumente precum WormGPT (un LLM open-source adaptat pentru sarcini ofensive) pentru a crea sarcini utile chiar în afara limitelor de detecție cunoscute.

Aceasta este versiunea de învățare automată a unui exploit zero-day.

Hacking AI vs. Hacking tradițional: Principalele diferențe

Hackerii AI folosesc inteligența artificială pentru a automatiza, îmbunătăți și extinde atacurile cibernetice AI. În schimb, hacking-ul tradițional necesită adesea scripturi manuale, expertiză tehnică aprofundată și investiții semnificative de timp. Diferența fundamentală constă în viteză, scalabilitate și accesibilitate: chiar și atacatorii novici pot lansa acum atacuri cibernetice sofisticate bazate pe inteligență artificială cu câteva indicații și un GPU de calitate superioară.

Aspect | Hacking AI | Hacking tradițional |

|---|---|---|

Viteza | Aproape instantanee cu automatizare | Scripting manual, mai lent |

Cerințe privind abilitățile | Pe bază de prompt; barieră de intrare redusă, dar necesită accesarea și reglarea modelului | Ridicat; necesită expertiză tehnică aprofundată |

Scalabilitate | Ridicat - suportă atacuri în mai multe etape asupra mai multor ținte | Limitat de timpul și efortul uman |

Adaptabilitate | Dinamic - inteligența artificială ajustează în timp real încărcăturile utile și modul de evitare | Scripturi statice sau semi-adaptabile |

Vectorii de atac | LLM-uri, deepfakes, atacuri ale modelelor de clasificare, agenți autonomi | Malware, phishing, recunoaștere manuală și exploatări |

Atenționări | Poate fi imprevizibil; lipsește intenția și contextul fără supraveghere umană | Control mai strategic, dar mai lent și manual |

Utilizarea abuzivă a IA și învățarea automată adversarială

Nu toate amenințările legate de inteligența artificială implică generarea de programe malware - unele vizează chiar sistemele de inteligență artificială. Tacticile adverse de învățare automată, cum ar fi injectarea promptă și otrăvirea modelului, pot manipula clasificatoarele, ocoli detecția sau corupe procesul decizional. Pe măsură ce inteligența artificială devine esențială pentru fluxurile de securitate, aceste atacuri evidențiază nevoia urgentă de testare robustă și de supraveghere umană.

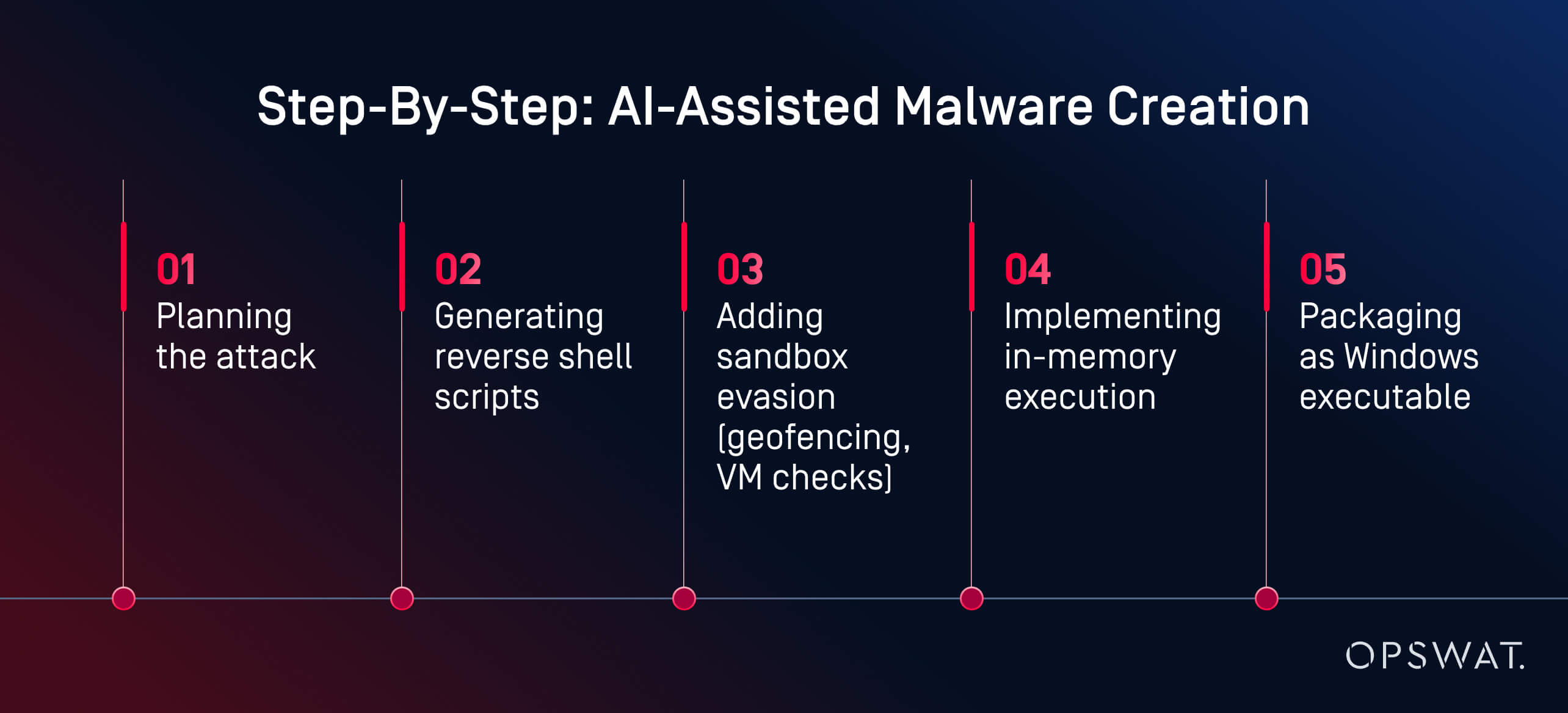

Modul în care inteligența artificială poate fi utilizată în mod abuziv pentru a dezvolta programe malware: O analiză a experților OPSWAT

Ceea ce înainte presupunea abilități avansate, acum necesită indicații și câteva clicuri.

În cadrul unui experiment live, Martin Kallas, expert în securitate ciberneticăOPSWAT , a demonstrat cum pot fi utilizate instrumentele AI pentru a crea malware evaziv rapid, ieftin și fără competențe avansate. Folosind HackerGPT, Martin a construit un lanț malware complet în mai puțin de două ore. Modelul l-a ghidat prin fiecare fază:

"AI-ul m-a ghidat în fiecare fază: planificare, ofuscare, evaziune și execuție", a explicat Martin. Rezultatul a fost "... o sarcină utilă generată de AI care a evitat detectarea de către 60 din cele 63 de motoare antivirus de pe VirusTotal". De asemenea, analiza comportamentală și sandboxing-ul nu au reușit să îl semnaleze ca fiind rău intenționat.

Acesta nu a fost un stat național. Nu a fost un hacker cu pălărie neagră. A fost un analist motivat care a folosit instrumente disponibile publicului pe un GPU de consum. Facilitatorul cheie? Modele AI găzduite local, fără restricții. Cu peste un milion de modele open-source disponibile pe platforme precum Hugging Face, atacatorii pot alege dintr-o bibliotecă vastă, le pot ajusta în scopuri rău intenționate și le pot rula fără supraveghere. Spre deosebire de serviciile bazate pe cloud, LLM-urile locale pot fi reprogramate pentru a ignora măsurile de protecție și a executa sarcini ofensive.

"Aceasta este ceea ce poate construi un amator motivat. Imaginați-vă ce ar putea face un stat național", a avertizat Martin. Exemplul său arată cum utilizarea abuzivă a IA poate transforma criminalitatea informatică dintr-o profesie calificată într-un flux de lucru accesibil, asistat de IA. În prezent, crearea de programe malware nu mai reprezintă un blocaj. Detecția trebuie să evolueze mai rapid decât instrumentele pe care atacatorii le au acum la îndemână.

Cum să vă apărați împotriva atacurilor cibernetice bazate pe inteligența artificială

Avem nevoie de o apărare stratificată, nu doar de o detectare mai inteligentă.

Apărarea sistemelor împotriva atacurilor cibernetice bazate pe inteligența artificială necesită o strategie pe mai multe niveluri care să combine automatizarea cu perspicacitatea umană și prevenirea cu detectarea. Principalele soluții de securitate cibernetică bazate pe inteligență artificială, precum platforma de prevenire avansată a amenințărilor OPSWAT, integrează prevenirea și detectarea. Urmăriți videoclipul pentru a afla mai multe.

Testarea securității AI și Red Teaming

Multe organizații apelează la echipe roșii asistate de inteligență artificială pentru a-și testa apărarea împotriva utilizării abuzive a LLM, a injecției prompte și a eludării clasificatorului. Aceste simulări ajută la descoperirea vulnerabilităților în sistemele integrate cu inteligența artificială înaintea atacatorilor.

Echipele roșii utilizează solicitări contradictorii, phishing sintetic și sarcini utile generate de AI pentru a evalua dacă sistemele sunt reziliente sau exploatabile. Testarea securității AI include, de asemenea:

- Modele Fuzzing pentru riscurile de injectare promptă

- Evaluarea modului în care LLM-urile gestionează intrările manipulate sau înlănțuite

- Testarea rezistenței clasificatorului la comportamentul evaziv

Liderii din domeniul securității încep, de asemenea, să își scaneze propriile LLM-uri pentru a detecta scurgeri de informații, halucinații sau acces neintenționat la logica internă, ceea ce reprezintă un pas esențial pe măsură ce AI-ul generativ este integrat în produse și fluxuri de lucru.

O stivă de apărare mai inteligentă: Abordarea OPSWAT

În loc să încerce să "combată IA cu IA" într-o buclă reactivă, Martin Kallas pledează pentru o apărare proactivă, pe mai multe niveluri. Soluțiile OPSWAT combină tehnologii care vizează întregul ciclu de viață al amenințărilor:

- Metascan™ Multiscanning: Rulează fișierele prin mai multe motoare antivirus pentru a detecta amenințările ratate de sistemele cu un singur motor antivirus

- MetaDefender Sandbox™: Analizează comportamentul fișierelor în medii izolate, detectând chiar și sarcinile utile generate de AI care eludează regulile statice

- Deep CDR™: Neutralizează amenințările prin reconstruirea fișierelor în versiuni sigure, eliminând exploatările încorporate

Acest pachet de securitate stratificat este conceput pentru a contracara natura imprevizibilă a programelor malware generate de inteligența artificială, inclusiv amenințările polimorfe, sarcinile utile în memorie și momelile deepfake care ocolesc instrumentele tradiționale. Deoarece fiecare strat vizează o etapă diferită a lanțului de atac, este suficient ca unul singur să detecteze sau să neutralizeze amenințarea și să prăbușească întreaga operațiune înainte ca aceasta să poată produce pagube.

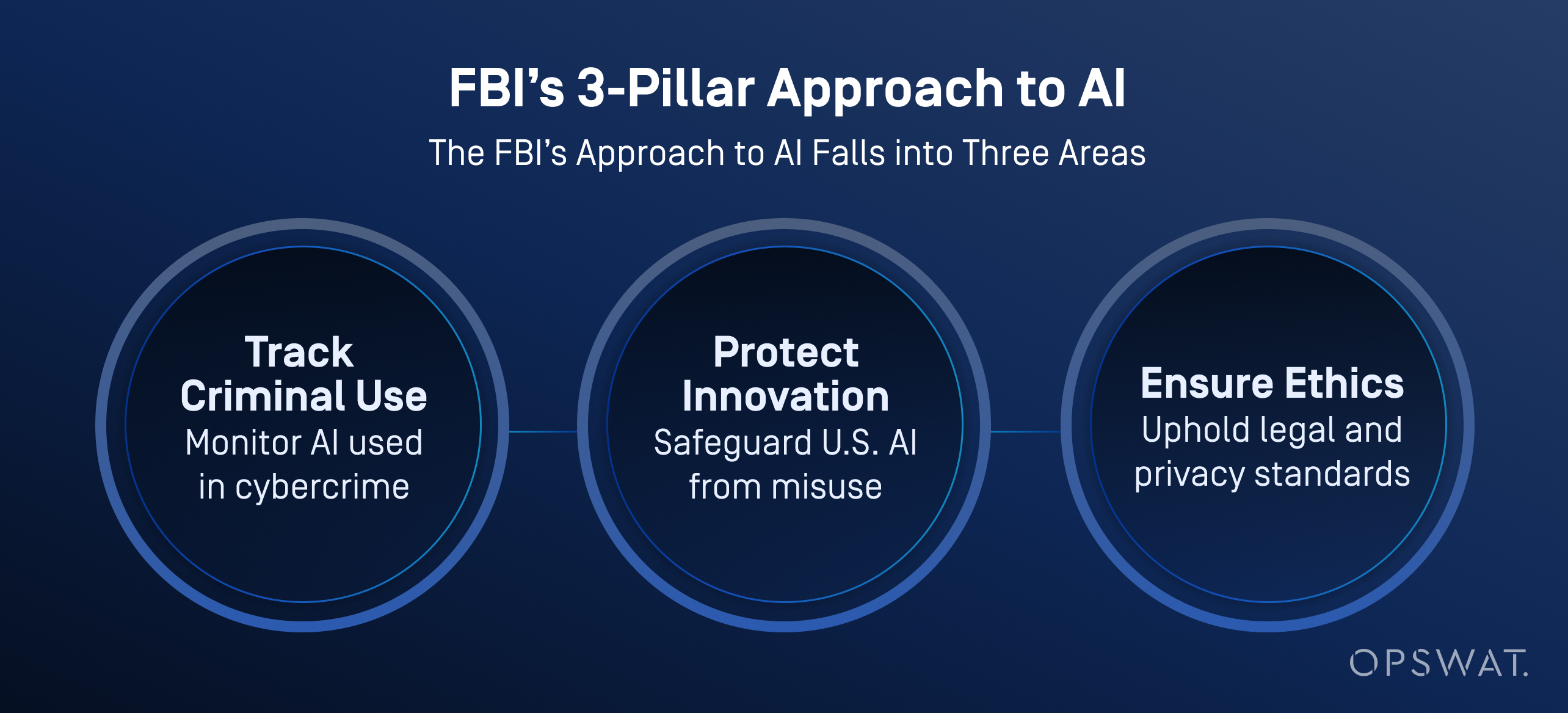

Cazuri de utilizare în industrie: Ce inteligență artificială utilizează FBI?

FBI și alte agenții americane integrează din ce în ce mai mult inteligența artificială în operațiunile lor de apărare cibernetică nu numai pentru a tria și prioritiza amenințările, ci și pentru a îmbunătăți analiza datelor, analiza video și recunoașterea vocii.

Potrivit FBI, inteligența artificială ajută la procesarea unor volume mari de date pentru a genera piste de investigație, inclusiv recunoașterea vehiculelor, identificarea limbilor și conversia vorbirii în text. Este important de reținut că biroul impune o supraveghere umană strictă: toate rezultatele generate de AI trebuie verificate de investigatori instruiți înainte de a se lua orice măsură.

IA nu înlocuiește procesul decizional uman. FBI subliniază că un om este întotdeauna responsabil pentru rezultatele investigațiilor și că IA trebuie utilizată într-un mod care să respecte viața privată, libertățile civile și standardele juridice.

Organizațiile sunt pregătite?

În ciuda creșterii numărului de amenințări bazate pe inteligența artificială, doar 37% dintre profesioniștii din domeniul securității afirmă că se simt pregătiți să oprească un atac cibernetic bazat pe inteligența artificială, după cum se arată în Raportul Ponemon privind starea securității cibernetice bazate pe inteligența artificială. Mulți se bazează încă pe planuri de gestionare a riscurilor cibernetice depășite și pe strategii de detectare reactive.

Calea de urmat necesită 4 pași esențiali:

- Adoptarea mai rapidă a instrumentelor de apărare bazate pe inteligența artificială

- Red teaming continuu și testarea promptă a riscurilor

- Utilizarea activă a Multiscanning, CDR și sandboxing

- Formarea analiștilor SOC pentru a lucra împreună cu instrumentele automate de investigare

IA a schimbat regulile. Nu este vorba despre înlocuirea oamenilor, ci despre oferirea instrumentelor necesare pentru a depăși atacurile care acum gândesc singure. Explorați modul în care platforma noastră ajută la securizarea fișierelor, dispozitivelor și fluxurilor de date în mediile IT și OT.

Întrebări frecvente (FAQ)

Ce este hackingul AI?

Hackingul cu inteligență artificială constă în utilizarea unor instrumente precum modele lingvistice de mari dimensiuni (LLM) pentru a automatiza sau îmbunătăți atacurile cibernetice. Aceasta îi ajută pe atacatori să creeze programe malware, să lanseze campanii de phishing și să ocolească apărarea mai rapid și mai ușor decât înainte.

Cum este utilizată inteligența artificială pentru criminalitatea informatică?

Infractorii folosesc inteligența artificială pentru a genera programe malware, a automatiza phishing-ul și a accelera scanările vulnerabilităților. Unele instrumente, precum cele vândute pe forumurile de pe internetul întunecat, pot chiar să-i conducă pe atacatori prin lanțuri complete de atac.

Care este diferența dintre hackingul AI și hackingul tradițional?

Hacking-ul tradițional necesită codare practică, utilizarea de instrumente și competențe tehnice. Hacking-ul AI reduce această barieră cu ajutorul modelelor care generează sarcini utile, scripturi și conținut de phishing din simple solicitări. Aceste tehnici fac atacurile mai rapide, mai scalabile și accesibile amatorilor.

Cum poate fi utilizată IA în mod abuziv pentru a dezvolta programe malware?

Inteligența artificială poate genera programe malware polimorfe, shell-uri inverse și sarcini utile de tip sandbox-evasive cu foarte puțină contribuție. După cum se arată într-o demonstrație live OPSWAT , un utilizator nemalicios a creat un malware de tip zero-day în mai puțin de două ore, folosind modele de inteligență artificială open-source care rulează pe un PC de jocuri.

Poate AI să înlocuiască hackerii?

Nu încă, dar se poate ocupa de multe sarcini tehnice. Hackerii încă își aleg țintele și obiectivele, în timp ce inteligența artificială scrie coduri, evită detectarea și adaptează atacurile. Riscul real este reprezentat de atacatorii umani, amplificați de viteza AI.

Ce este un hacker AI?

Un hacker AI este o persoană sau un sistem semi-autonom care utilizează AI pentru a lansa atacuri cibernetice, a automatiza programe malware sau a desfășura campanii de phishing la scară largă.

Ce inteligență artificială folosește FBI?

FBI utilizează inteligența artificială pentru triajul amenințărilor, analiza criminalistică, detectarea anomaliilor și prelucrarea probelor digitale. Aceste instrumente ajută la automatizarea investigațiilor și la apariția cazurilor cu prioritate ridicată, reducând în același timp volumul de muncă al analiștilor.

Care este un exemplu de atac al inteligenței artificiale?

Un caz real a implicat e-mailuri de phishing generate de inteligența artificială în timpul perioadei de înscriere la beneficii a unei companii. Atacatorii s-au dat drept cei de la resurse umane pentru a fura acreditările. Într-un alt caz, AI a ajutat la automatizarea atacurilor ransomware, forțând o marcă multinațională să își închidă operațiunile.

Ce sunt atacurile cibernetice ale IA?

Atacurile cibernetice AI sunt amenințări dezvoltate sau executate cu ajutorul inteligenței artificiale. Printre exemple se numără phishing-ul generat de inteligența artificială, impersonările deepfake, injectarea promptă și eludarea clasificatorului. Aceste atacuri ocolesc adesea sistemele de apărare tradiționale.

Cum folosesc hackerii și escrocii inteligența artificială pentru a viza oamenii?

Hackerii folosesc inteligența artificială pentru a personaliza e-mailurile de phishing, pentru a clona vocile pentru înșelăciunile telefonice și pentru a genera videoclipuri deepfake pentru a înșela țintele. Aceste tactici exploatează încrederea umană și fac chiar și utilizatorii bine instruiți vulnerabili la înșelăciunile realiste, create de AI.

Cum mă pot apăra împotriva atacurilor bazate pe inteligența artificială?

Utilizați o apărare pe mai multe niveluri: Multiscanning, sandboxing, CDR și red teaming condus de oameni. Atacurile AI se mișcă rapid. Apărătorii au nevoie de automatizare, context și viteză pentru a ține pasul.